Ya ha caído el primer libro del verano, uno de esos que compro en pleno lío del año y que sé, solo podré leer en esta época. Se llama «Evidence-Based Policy: A Practical Guide to Doing it Better» de la filósofa de la ciencia de la Universidad de California en San Diego, la empirista Nancy Cartwright (mentora de Jacob Stegenga y de la escuela de Ian Hacking; es, de hecho -y este es un cotilleo- su ex esposa) y Jeremy Hardie, investigador del Center for Philosophy of Natural and Social Sciences de la London School of Economics an Political Science, institución que fundó la propia Cartwright.

https://www.jclinepi.com/article/S0895-4356(98)00004-3/fulltext

El texto fue publicado en 2012 y es muy extraño la poca visibilidad que ha tenido en la bibliografía médica: es una crítica profunda a la extrapolación de los resultados de los ensayos clínicos y unas propuestas para poder actuar mejorando lo que denominamos comúnmente la “validez externa” de los ECAs, algo que Feisntein definió como una verdadera tragedia clínico-estadística. El libro está dedicado a la Política Basada en la Evidencia (PBE) pero es completamente aplicable a la MBE con algún pequeño matiz.

Para los impulsores en España de la Oficina de Información Científica (OIC) siento decir que no existe tal cosa llamada Política Basada en la Evidencia. Hay cada vez más ensayos clínicos sobre intervenciones sociales, educativas o de salud pública pero lo que no existe es la posibilidad de su aplicación directa en otros contextos; en política, mucho menos que en medicina. La aplicación de los resultados de ensayos clínicos validados en un contexto determinado no es posible en otros: eso es, para los autores, hacer “mala política”. Pero el mensaje de la Política Basada en la Evidencia, como el de MBE, es sumamente atractivo para políticos y empresas que, como sabemos, instrumentalizan la ciencia para sus intereses imponiendo “sus evidencias” como objetivas y neutras (no en vano, la iniciativa de la OIC está sustentada por la Fundación COTEC financiada por las principales empresas tecnológicas de España incluyendo farmacéuticas como Almirall).

En efecto, la tesis de los autores es que contar con un ensayo clínico válido no permite extrapolar los resultados de manera directa. Es decir, pasar del «funcionó» (eficacia) al «funcionará» (efectividad) es un salto que no puede realizarse sin un «gran esfuerzo intelectual y práctico». Para que el resultado de un ECA con un fármaco u otra intervención sanitaria sea “relevante” en una situación concreta hace falta mucha más información. Es un «proceso de pensamiento abierto que será inevitablemente contextual y no reducible a reglas» (p 11) avisan los autores. Es decir, casi lo contrario a cómo utilizamos los resultados de la MBE en la actualidad: como inputs de un proceso decisional algorítmico (basado en reglas) y de aplicación universal (no contextual).

Sobre el tipo de información que hace falta para dar este salto es sobre lo que versa el texto. Para los autores, cuando tenemos un ECA correcto metodológicamente (validez interna) acaba de comenzar un laborioso proceso de investigación pragmática que conducirá a poder realizar una «predicción de efectividad».

Ese laborioso proceso nunca ha sido claramente especificado en medicina. Sackett alude vagamente a la integración de las mejores evidencias con la experiencia del profesional y los valores del enfermo. Laporte, en su fabuloso manual «Principios Básicos de Investigación Clínica«, dedica un capítulo a este problema titulado «Extrapolación de los resultados de ensayos clínicos a la práctica médica».

Además de la muy útil Tabla que copio arriba, y que señala las diferencias entre un experimento y la práctica habitual, el profesor Laporte describe la “tragedia de Feinstein” con otras palabras:

“Aunque parezca paradójico, a pesar de que el ensayo clínico es el método epidemiológico más fiable para el estudio de relaciones de causalidad, su misma naturaleza determina que no esté intrínsecamente diseñado para identificar a los pacientes que responderán favorablemente (o desfavorablemente) al tratamiento. Esto limita su valor para la toma de decisiones relativas a la prescripción para pacientes determinados.”

El profesor Laporte es más específico en el diagnóstico del problema que en su tratamiento y propone soluciones como la realización de más ensayos clínicos para cada circunstancia específica (algo, como reconoce, poco realista y que, además, añadimos, no serviría para solucionar el problema de la extrapolación) o la incorporación de los valores de los pacientes.

Jacob Stegenga, el alumno aventajado de Cartwright, también dedica parte del capítulo 8, “Measuring effectiveness” -de su aclamado “Medical Nihilism”– al problema de la extrapolación.

http://www.ebcp.com.br/simple/upfiles/livros/005EEBM.pdf

La recomendación más extendida en la literatura “main stream” de la MBE en relación con la extrapolación es lo que Stengenga llama “simple extrapolation, unless” (SEU) (extrapolación simple, a no ser que). La cita más repetida para ejemplarizar este proceso es la de Guyatt y colaboradores de 2001:

“(para poder hace una extrapolación) pregúntese si existe algún problema por el que los resultados de un ensayo clínico no puedan ser aplicados en el caso concreto de un paciente individual. Lo más probable es que no encuentre ninguna razón y, por tanto, casi siempre, pueden generalizarse los resultados de los ensayos clínicos a los enfermos reales”

https://www.ncbi.nlm.nih.gov/pubmed/22862884

En otro texto, se explica cómo se resuelve por la vía rápida el problema de la extrapolación:

“las terapias, especialmente los fármacos, que se muestran eficaces en una muestra estrecha de pacientes generalmente se muestran igual de efectivos cuando se aplican en enfermos de un espectro más amplio”

https://www.ncbi.nlm.nih.gov/pubmed/23692224

Lo cierto es que la SEU es una versión un poco más sofisticada del proceso decisional que con más frecuencia se realiza en la toma de decisiones médicas cada día que es la extrapolación simple, es decir, aplicar directamente los resultados de los ensayos clínicos o meta-análisis a los casos particulares. Cita Stegenga una revisión de Fuller de Guías de Práctica Clínica para ancianos, que teóricamente adaptaban recomendaciones para la utilización de cinco clases de fármacos muy prevalentes en personas mayores, en las que no se especifica ninguna consideración sobre posibles límites de la aplicabilidad de los resultados de los ECAs a esta población.

La extrapolación se realiza, en la inmensa mayoría de los casos, en la clínica y en los documentos de difusión de la evidencia, como mucho, por defecto: se asume su corrección a no ser que haya una razón en contra. Esta forma de extrapolar resultados de ECAs a pacientes reales es para Stegenga una simplificación epistémica y una fuente de error. Habría varias razones:

La primera razón es asumir que las diferencias entre la muestra experimental y la población real son poco relevantes. Si consideramos los estrictos criterios de inclusión y exclusión utilizados en los ECAs es bastante obvio que la población real será diferente en muchos aspectos.

https://onlinelibrary.wiley.com/doi/abs/10.1111/jep.12021

Por ejemplo, en el ensayo clínico RECORD realizado para evaluar la seguridad de la rosiglitazona, los sujetos de la muestra experimental tenían de media una mejor salud cardiovascular que la población general.

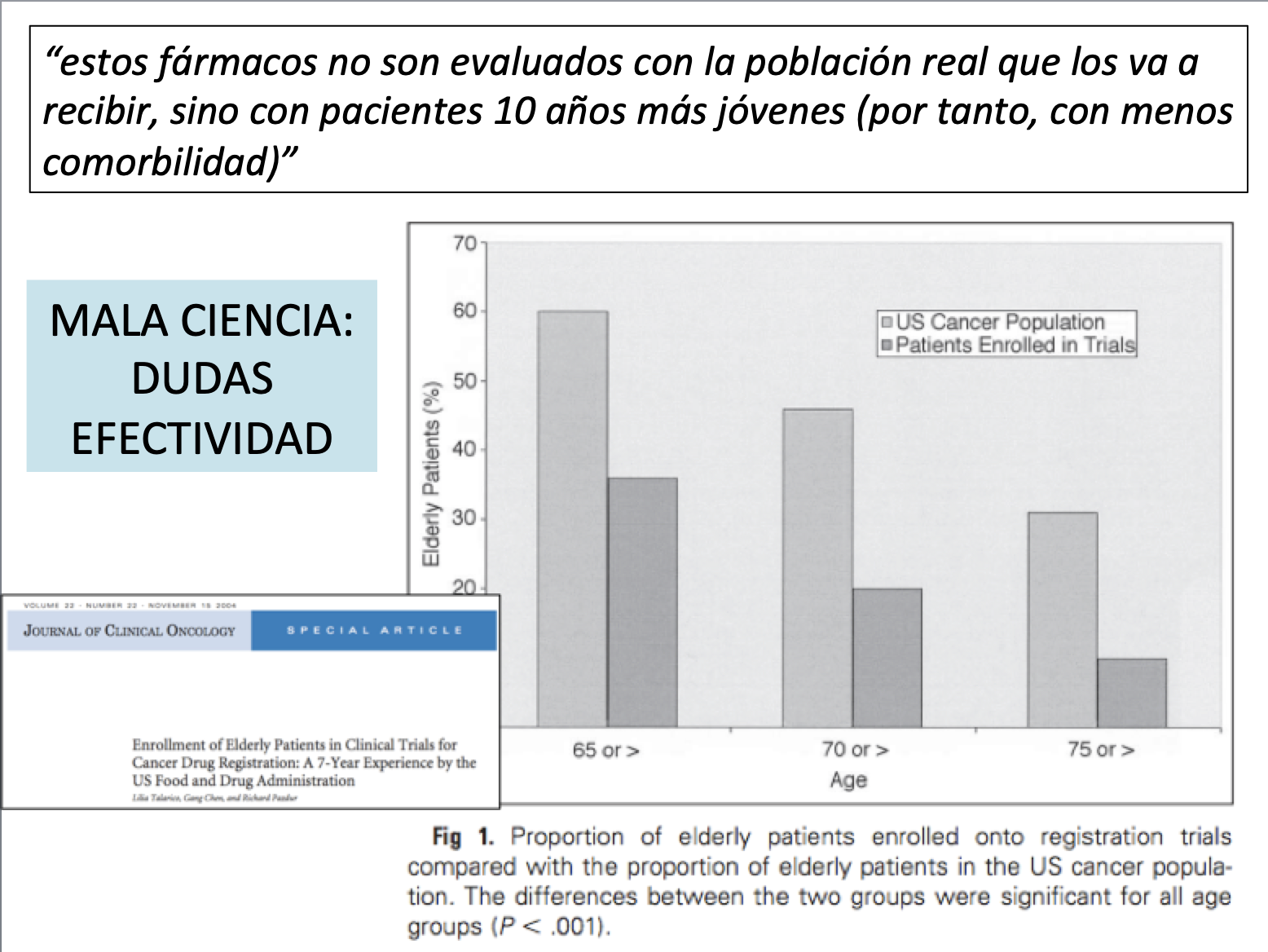

También conocemos que los ECAS con quimioterápicos se hacen en una población unos 10 años de media más joven que la población real que acaba recibiendo el medicamento.

La segunda razón para considerar la extrapolación una simplificación epistémica que lleva fácilmente al error es la existencia del sesgo de publicación. Asumiendo la validez interna del ECA y que no hubiera diferencias sustantivas entre los sujetos de la muestra experimental y de la real, el prevalente sesgo de publicación impide una ponderación ecuánime de la eficacia del producto con lo que cualquier extrapolación está probablemente sobrevalorando la utilidad del medicamento.

La tercera razón de Stegenga es que el ECA ignora otras variables distintas a la intervención evaluada (el fármaco) que hacen que el experimento haya salido positivo. En este apartado es donde Stegenga cita el trabajo de su maestra Cartwright y nos permite unir sus reflexiones.

En efecto, Cartwright y Hardie desarrollan en su obra una “teoría de la relevancia”. Para que los resultados de un ECA sean relevantes para otra población o para un enfermo concreto deben realizarse antes de su aplicación dos procesos de investigación. El primero lo denominan investigación horizontal y sirve para determinar si los factores de soporte existentes en el ECA están presente en un grado suficiente en el nuevo contexto. El segundo proceso de investigación es denominado investigación vertical que analiza si los factores causales que contribuyeron a los resultados del ECA están presentes en la nueva situación donde se pretende conseguir los mismos resultados.

Los ensayos clínicos son “trozos de verdad” muy especiales porque consideran que todo el efecto (normalmente positivo) descrito depende de la intervención («They clinch causal conclusions»). Es decir, en un ECA positivo, se asume que si hay otros factores causales implicados en el resultado han sido neutralizados mediante el proceso de aleatorización y enmascaramiento y, por tanto, que están distribuidos homogéneamente entre los grupos intervención y control.

De alguna manera el ECA es un proceso que se auto-valida: el diseño del experimento es lo que garantiza que el estudio cumple los presupuestos necesarios para considerar las conclusiones validas. Un diseño válido parece conducir automáticamente a unas conclusiones válidas y hace innecesario conocer otros factores causales implicados. De este modo las conclusiones del ECA son aceptables aunque no sepamos por qué la intervención funciona, o sea, no conozcamos ni los factores causales ni los de soporte implicados.

Esta base teórica débil es sumamente atractiva y es la que empleamos con las maquinas: no sabemos cómo funcionan ni nos importa; solo sabemos/queremos que funcione. Pero un medicamento eficaz en un ECA no puede ser conceptualizado como una máquina ya que se aplica a un sistema biológico complejo en el que existen muchas y cambiantes variables. Por eso es necesario, antes de aplicar los resultados de un ECA a un paciente, realizar un proceso de investigación horizontal y otro de investigación vertical.

Investigación horizontal: los factores de soporte

Cartwright y Hardie utilizan un ejemplo no médico. En 1990 California evalúo el desempeño de sus escolares como muy deficiente y decidió realizar una intervención a gran escala para la reducción del número de alumnos por clase intentando mejorar sus resultados. La intervención californiana se basaba en un exitoso ensayo clínico realizado en Tennessee. Sin embargo, al evaluar los resultados a los 20 años, tras un gasto de más de 1000 millones de dólares, se comprobó que la intervención de Tennessee no había eficaz en California. ¿Por qué?

Cartwright y Hardie argumentan que en California no existían los mismos factores de soporte que permitieron que la reducción del número de alumnos fuera eficaz en Tennessee. Una investigación horizontal previa a la implementación del experimento de Tennessee en California hubiera señalado otros factores existentes que contribuyeron a mejorar el rendimiento escolar distintos a la reducción del número de alumnos como, por ejemplo, la disponibilidad de espacio en los colegios y la existencia de maestros cualificados. En California no existía espacio extra en la mayoría de los abarrotados colegios con lo que se utilizaron aulas que servían para clases de apoyo; además, no había suficientes profesores con lo que la ampliación del número de clases conllevó la contratación de más de 12.000 profesores noveles.

El rendimiento escolar depende efectivamente de la reducción del número de alumnos en las clases siempre y cuando se garantice la existencia de los otros factores de soporte que también influyen: profesores cualificados y conservar clases de apoyo y clases con materias extra. Ninguno de estos factores de soporte fueron garantizados en California por lo que su experiencia fracasó.

La conclusión es que no se puede realizar una extrapolación de una intervención que ha sido positiva en un contexto a otro sin efectuar una investigación de otros factores de soporte implicados. Las extrapolaciones realizadas con medicamentos, especialmente en intervenciones preventivas, suelen obviar los factores de soporte que están presentes en la muestra experimental pero que no lo están en el paciente real. La reducción de la glucemia, la hiperlipidemia o la TA puede tener efectos positivos en poblaciones seleccionadas con factores de soporte semejantes y estables (adherencia al tratamiento, no multimorbilidad o polimedicación, condiciones de vida y socioculturales semejantes..) pero no tener ninguno o incluso empeorar resultados en salud en otros pacientes donde no se dan dichos factores de soporte.

De hecho, Cartwright y Hardie señalan que el proceso de investigación horizontal puede descubrir factores de soporte que deberían ser implementados antes que la intervención que demostró efectividad en el ECA. Por ejemplo, cuando en un enfermo es mucho mas efectivo el fomento del ejercicio o la pérdida de peso que el tratamiento farmacológico de la hipertensión o la hiperglucemia.

¿Existen intervenciones sanitarias o farmacológicas que no requieren considerar los factores de soporte antes de ser extrapoladas? Muy pocas. Son las llamadas “balas mágicas” como los antibióticos o las intervenciones quirúrgicas efectivas como la apendicectomía. El problema es que la bala mágica es muy poco frecuente y normalmente tiene unos requisitos: relación de causalidad inmediata en el tiempo, efectividad etiológica y sintomática o una relación riesgo beneficio muy obvia. Lo cierto es que, por ejemplo, no existen balas mágicas en la farmacología preventiva y muy pocas en la que trata los procesos agudos.

Investigación vertical: los factores causales

Además de la investigación horizontal los autores señalan la necesidad de realizar una investigación vertical que analice los procesos causales implicados. El debate entre los empiristas -que defienden que no es necesario conocer los factores causales sino si la intervención es efectiva- y aquellos mecanicistas –que creen que es importante conocer si la intervención incide en alguno de los procesos causales- es largo en medicina. Este debate lo abordaremos en otra entrada cuando comentemos otro de los libros del verano pero Cartwright y Hardie no hablan tanto de conocer los factores causales inmediatos sino de los mediatos, es decir, de las causas de las causas.

Por ejemplo, sabemos la causalidad inmediata vinculada a la utilización de un inhibidor de la enzima convertidora de la angiotensina (IECA) pero es necesario conocer también otros factores causales en su “máximo nivel de abstracción” que pueden llegar a determinar un fallo de la intervención con IECAs en otro contexto donde la hipertensión, por ejemplo, no sea esencial sino secundaria. Esta investigación es diferente, como vemos, de la horizontal.

CONCLUSIONES

Los autores terminan señalando lo obvio: la posición privilegiada de los ECAs en los procesos de toma de decisiones clínicas no está justificada. Un resultado positivo de un ECA es un buen comienzo pero un profesional que no sea negligente debe realizar un proceso intelectual mucho más sofisticado (excepto que nos encontremos ante una de las escasas “balas mágicas” que existen en medicina) que “saberse las evidencias” a la hora de aplicarlas a una población o paciente determinado. Ese proceso intelectual de adaptación de las evidencias a la realidad –de análisis de la relevancia- se llama juicio clínico y debería apoyarse en alguna forma de investigación horizontal y vertical para tener ciertas garantías. Los autores proponen un marco de acción específico y esta es la novedad de la obra, en comparación con otras recomendaciones más generales.

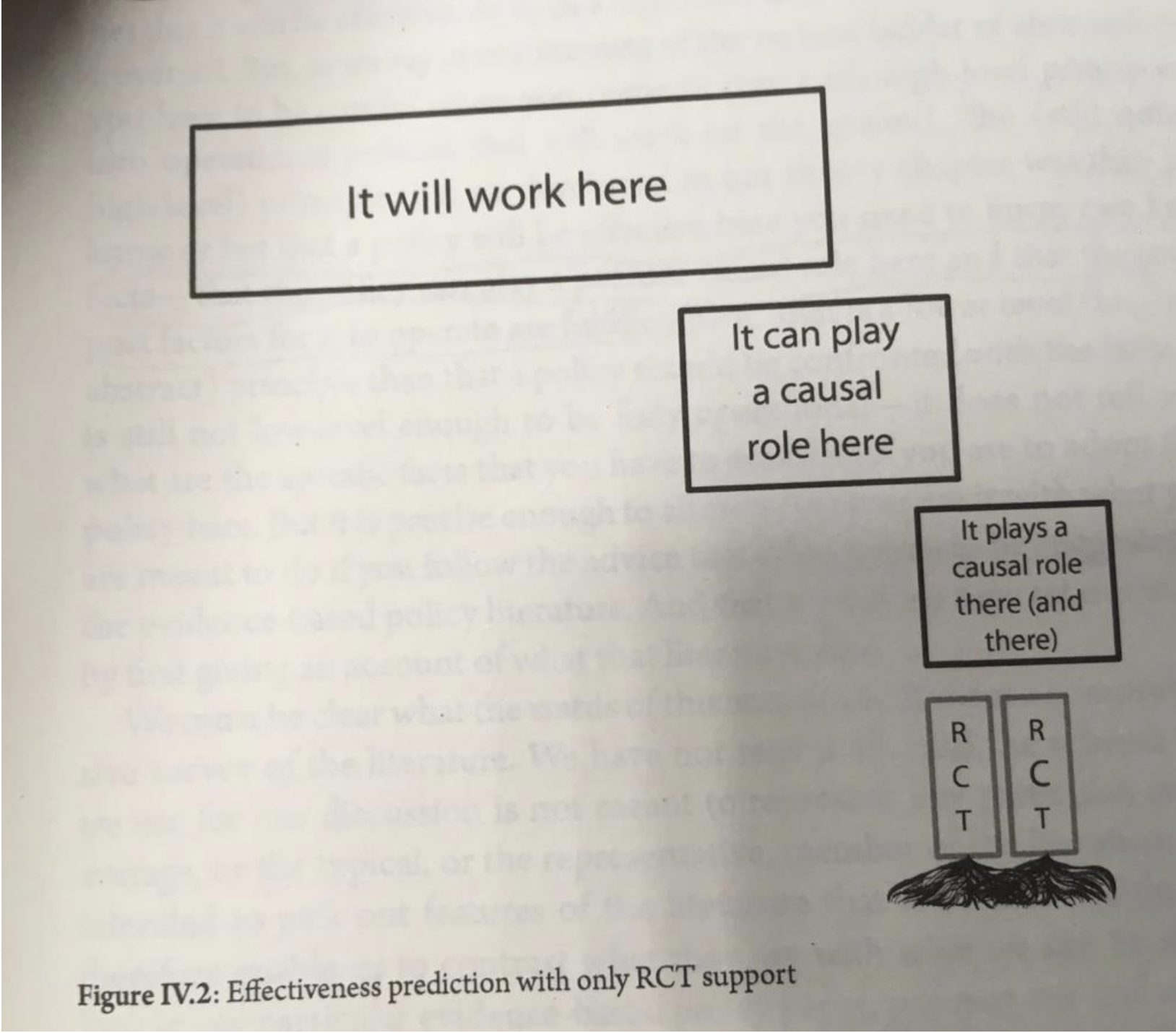

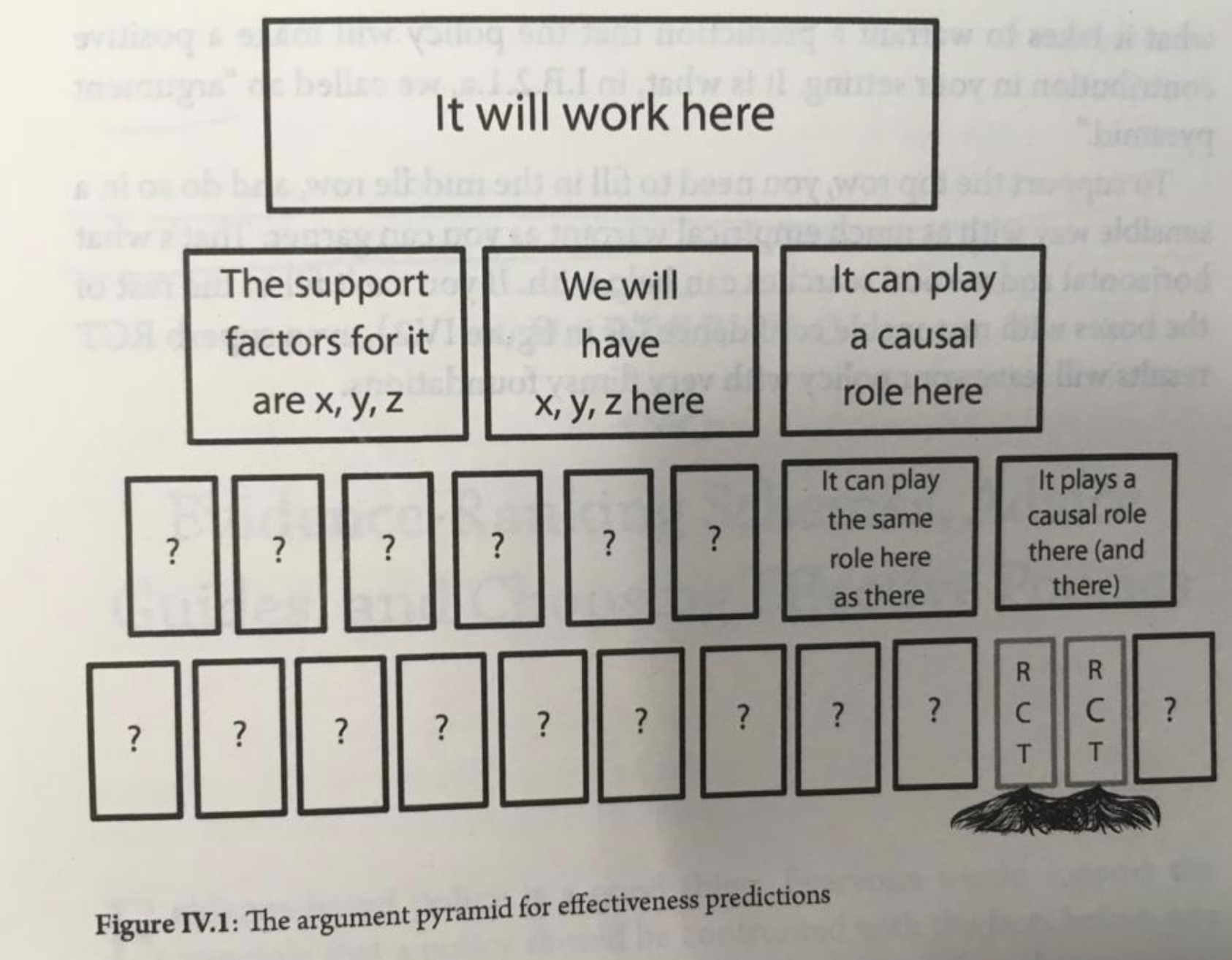

En las imágenes vemos la diferente complejidad de considerar que con el resultado de un ECA ya sabemos qué hay que hacer con un enfermo o una población o aceptar que solo es un principio que requiere más investigación.

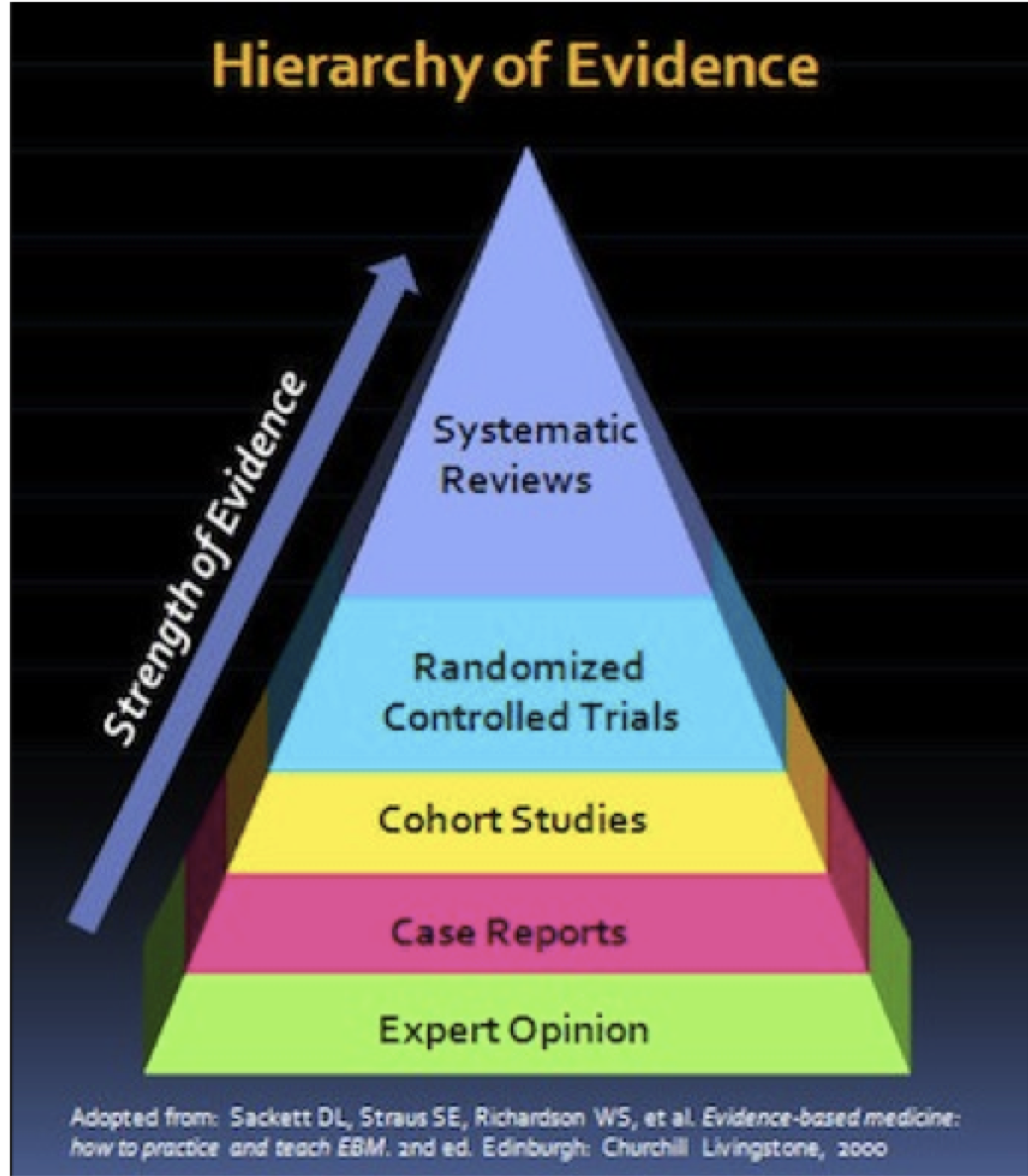

En definitiva, un ECA (y sus derivados), una prueba que se categoriza como de “alta calidad”, es lo mejor que tenemos para evaluar la eficacia de una intervención que existe pero no para ponderar su efectividad:

“Nuestro problema no es con las jerarquías de la evidencia sino con que se considere que estar en el top del ranking permite predecir que una intervención funcionará aquí” (p 138)

Y de manera más explícita:

“De acuerdo con nuestra distinción entre confiable y relevante, asumir que las pruebas científicas categorizadas como de alta calidad son suficientes para dar por hecho que la intervención funcionará en un contexto determinado es una mala presunción en términos de relevancia” (p 139)

La última parte del libro de Cartwright y Hardie está dedicada a la deliberación, que no es “la segunda mejor manera de evaluar la efectividad” sino “lo que hay que hacer”:

“Para responder a nuestros problemas centrales sobre los factores causales y de soporte tenemos que pensar, es decir, deliberar. Al igual que la ortodoxia sobre MBE ha olvidado reflexionar sobre la relevancia, también lo ha hecho sobre la deliberación. La ortodoxia de la MBE al alentar procesos de toma de decisiones basados en reglas está impidiendo que los decisores piensen, ya que trasmiten que la evidencia elimina la discrecionalidad y la necesidad de juicio; y la deliberación necesita discrecionalidad y juicio… Y esa deliberación necesaria para ejercer la discrecionalidad adecuadamente exige una serie de virtudes intelectuales y prácticas muy diferentes a la de conformidad”

Evaluando la causalidad en medicina

¿Qué podemos hacer entonces para no quedar paralizados por la incertidumbre? Lo primero asumir la complejidad y evitar los cómodos y satisfactorios atajos cognitivos que llevan a la aplicación directa de las evidencias. Lo segundo, retomar los consejos del inventor del ensayo clínico, Bradford Hill

Al final del capítulo 6 sobre la maleabilidad del meta-análisis de su obra «Medical Nihilism» Stegenga propone una alternativa para sintetizar la evidencia que denomina la estrategia Hill:

«Una antigua tradición vinculada al epidemiólogo Sir Bradford Hill pone a nuestra disposición un procedimiento más consistente para considerar todos los tipos de evidencia producidos por la investigación médica»

Cuando Bradford Hill utilizó la fuerte correlación entre el tabaco y el cáncer de pulmón, en la década de los 50, para determinar su causalidad, el estadístico Ronald Fisher criticó la falta de evidencia experimental controlada que permitiera establecer dicha causalidad: podría existir una causa común, como una predisposición genética compartida entre los fumadores y los que desarrollaban un cáncer de pulmón, argüía Fisher.

Hill respondió que la causalidad que defendía, estaba basada en diferentes juicios y criterios:

(1) Asociación estadística: con cualquier estudio, incluyendo estudios de cohortes y de casos y controles;

(2) Constancia o consistencia: conocer si la relación entre las dos variables ha sido confirmada por más de un estudio, en poblaciones y circunstancias distintas, y por autores diferentes,

(3) Especificidad: es más fácil aceptar una relación causa-efecto cuando para un efecto solo se plantea una única etiología, que cuando para un determinado efecto se han propuesto múltiples causas,

(4) Temporalidad

(5) Relación dosis-respuesta: gradiente biológico, es decir, la frecuencia de la enfermedad o la efectividad aumenta con la dosis o el nivel de exposición,

(6) Plausibilidad biológica

(7) Coherencia: la interpretación de causas y efectos no puede entrar en contradicción con el comportamiento propio de la enfermedad o lesión; este criterio combina aspectos de consistencia y plausibilidad biológica,

(8) Experimentación: criterio deseable de alta validez,

(9) Analogía: si un factor de riesgo produce un efecto a la salud, otro con características similares debería producir el mismo impacto sobre la salud.

Hill señaló que no existían criterios necesarios ni suficientes y que el juicio de causalidad debería considerar todos de una manera agregada y/o cualitativa.

Lo más notable para Stegenga es que este procedimiento «cuasi cualitativo» contrasta fuertemente con la jerarquización de la evidencia propuesta por la MBE:

«La evidencia de causalidad no puede proceder solo de una media numérica de efectos cuantificados y con tantas posibilidades de maleabilidad»

Aunque es verdad que la estrategia Hill no evita la posibilidad de maleabilidad sí que permite sintetizar toda la evidencia disponible sin rechazar ninguna simplemente por proceder de una metodología que ha sido calificada como de inferior categoría:

«Contrariamente a lo que pasa con el meta-análisis, no se utiliza un simple algoritmo para amalgamar las diversas formas de evidencia»

Stegenga reconoce que la maleabilidad no es evitable:

«La complejidad requerida para evaluar y amalgamar la enorme cantidad de evidencias existentes hace inevitable su maleabilidad. Pero la estrategia Hill es más fiable que los meta-análisis»

Ambos métodos, la estrategia Hill y el meta-análisis, requieren juicios de valor. La diferencia es que Hill lo reconoce y la jerarquía de la evidencia de la MBE, que santifica el meta-ánálisis, lo oculta.

Si hay que elegir entre «niveles de maleabilidad», elijamos el procedimiento con más probabilidades de acercarse a la verdad que, contrariamente a lo que nos han transmitido desde la MBE, no está basado en números.

Abel Novoa es médico de familia y presidente de NoGracias

De aquellos polvos… La grotesca derivación de, entre otros, los «azotes» del «No-sin-evidencia» y agentes del MEADO, que han puesto demasiado compromiso personal (facultativos, ¡ay!. incluidos) en someter todo ejercicio médico, toda su bimilenaria deontología y, ¡horror!, toda su ética al imperio de esta «ciencia» de garrafón epistémico como para recapacitar y rectificar.

Ya van y vamos tarde, ahora que la armada «evidente» anda ultimando su asalto al código fuente, la «ciencia en el parlamento».

Lo que inicialmente fue un simple error de traducción de un concepto mal entendido y peor asimilado por muchos (prueba, que no «evidencia»), se convirtió después en bandera de simplones epistémicos, de mecánicos reduccionistas de todo pelo en posiciones de influencia comunicacional y corporativa profesional.

La peor de las gestiones posibles en Medicina de las impagables, exclusivas pero no excluyentes aportaciones de la ciencia, elevarla a dogma en nuestra profesión.

Y, a la que nos descuidemos, también en el poder legislativo.